Índice de contenido

Google llevó a cabo su conferencia anual de desarrolladores «Google I/O» con una gran cantidad de noticias sobre inteligencia artificial, incluyéndola en cada aplicación y servicio de la compañía. El discurso de apertura mostró productos clave como su modelo insignia Gemini AI, que ahora tiene una versión Flash más rápida para competir con la nueva y más rápida iteración GPT, GPT-4o que OpenAI anunció un día antes.

Te contamos sobre las principales actualizaciones importantes del Google I/O 2024, junto con algunos anuncios adicionales que se produjeron después de la conferencia magistral.

Gemini 1.5 Flash y actualizaciones a Gemini 1.5 Pro

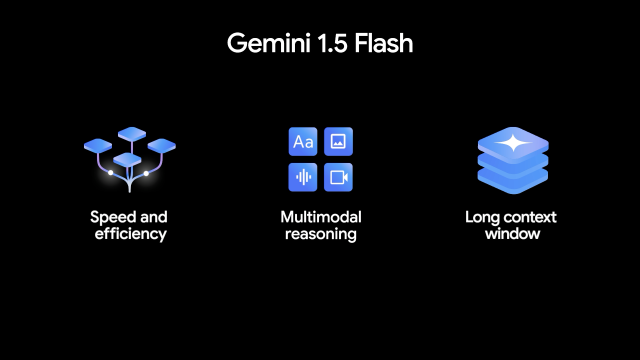

Google anunció un nuevo modelo de inteligencia artificial llamado Gemini 1.5 Flash, que, según dice, está optimizado para brindar velocidad y eficiencia. Flash se encuentra entre Gemini 1.5 Pro y Gemini 1.5 Nano, que es el modelo más pequeño de la compañía que se ejecuta localmente en el dispositivo.

Google dijo que creó Flash porque los desarrolladores querían un modelo más liviano y menos costoso que Gemini Pro para crear aplicaciones y servicios impulsados por inteligencia artificial y al mismo tiempo mantener algunas de las cosas como una ventana de contexto larga de un millón de tokens que diferencia a Gemini Pro de los modelos de la competencia.

A finales de este año, Google duplicará la ventana de contexto de Gemini a dos millones de tokens, lo que significa que podrá procesar dos horas de vídeo, 22 horas de audio, más de 60.000 líneas de código o más de 1,4 millones de palabras al mismo tiempo.

Proyecto Astra

Google mostró el Proyecto Astra, una primera versión de un asistente universal impulsado por IA que, según el director ejecutivo de DeepMind de Google, Demis Hassabis, era la versión de Google de un agente de IA «que puede ser útil en la vida cotidiana».

En un vídeo que, según Google, se grabó en una sola toma, un usuario de Astra se mueve por la oficina de Google en Londres sosteniendo su teléfono y apuntando con la cámara a varias cosas (un altavoz, algún código en una pizarra y hacia una ventana) y tiene una conversación natural con la aplicación sobre lo que parece. En uno de los momentos más impresionantes del video, le dice correctamente al usuario dónde dejó sus anteojos antes sin que el usuario los haya mencionado.

El video termina con un giro: cuando el usuario encuentra y usa las gafas perdidas, nos enteramos de que tiene un sistema de cámara integrado y es capaz de usar el Proyecto Astra para mantener una conversación sin problemas con el usuario, lo que tal vez indique que Google podría estar trabajando en un competidor de las gafas inteligentes Ray Ban de Meta.

Pregúntale a Google Fotos

Google Photos ya era inteligente a la hora de buscar imágenes o vídeos específicos, pero con la IA, Google está llevando las cosas al siguiente nivel. Si es suscriptor de Google One en los EE.UU., podrá hacerle a Google Photos una pregunta compleja como «muéstrame la mejor foto de cada parque nacional que he visitado» cuando la función se implemente en los próximos meses. Google Photos utilizará la información del GPS, así como su propio criterio sobre qué es «mejor» para presentarle opciones. También puede pedirle a Google Photos que genere epígrafes para publicar las fotos en las redes sociales.

Veo e Imagen 3

Los nuevos motores de creación de medios impulsados por IA de Google se llaman Veo e Imagen 3. Veo es la respuesta de Google a Sora de OpenAI. Puede producir vídeos de 1080p de “alta calidad” que pueden durar “más de un minuto”, dijo Google, y puede comprender conceptos cinematográficos como un lapso de tiempo.

Imagen 3, mientras tanto, es un generador de texto a imagen que, según Google, maneja el texto mejor que su versión anterior, Imagen 2. El resultado es el modelo de texto a imagen de mayor calidad de la compañía con un «increíble nivel de detalle» para «imágenes fotorrealistas y realistas” y menos artefactos, esencialmente comparándolo con DALLE-3 de OpenAI.

Grandes actualizaciones para Google Search

Google está realizando grandes cambios en el funcionamiento fundamental de su buscador. La mayoría de las actualizaciones anunciadas incluyen la capacidad de hacer preguntas realmente complejas y el uso del buscador para planificar comidas y vacaciones no estará disponible a menos que opte por registrarse en Search Labs, la plataforma de la compañía que permite a las personas probar funciones experimentales.

Pero una gran característica nueva que Google llama AI Overviews y que la compañía ha estado probando durante un año, finalmente se está implementando para millones de personas en los EE. UU. El buscador de Google ahora presentará respuestas generadas por IA además de los resultados de forma predeterminada, y la compañía dice que llevará la función a más de mil millones de usuarios en todo el mundo para fin de año.

Gemini en Android

Google está integrando Gemini directamente en Android. Cuando se lance Android 15 a finales de este año, Gemini conocerá la aplicación, la imagen o el video que estás ejecutando y podrás abrirlo como una superposición y hacerle preguntas específicas del contexto. ¿Dónde deja eso al Asistente de Google que ya hace esto? ¡Quién sabe! Google no mencionó el tema en absoluto durante el evento.

A continuación un resumen de 10 minutos del evento Google I/O 2024.